8月25日、ユークスの平野晶麗氏が、ゲーム開発者向け会議CEDEC2021にて「ALiS ZEROにおけるライブへの取り組み」と題した講演を行った。

「ALiS ZERO」は、ユークスが運営するARダンスボーカルグループ「ARP」のライブに使われているARライブシステムだ。ほかに「22/7」などの作品にも活用されている。

「観客の皆様に一期一会の感動」を提供するために、「実在するパフォーマーのライブと遜色のない品質、そしてARのパフォーマーがまさにそこにいるという存在感」を実現するべく、ライブシステムを自社開発してきたという。そのこだわりの一端をご紹介していきたい。

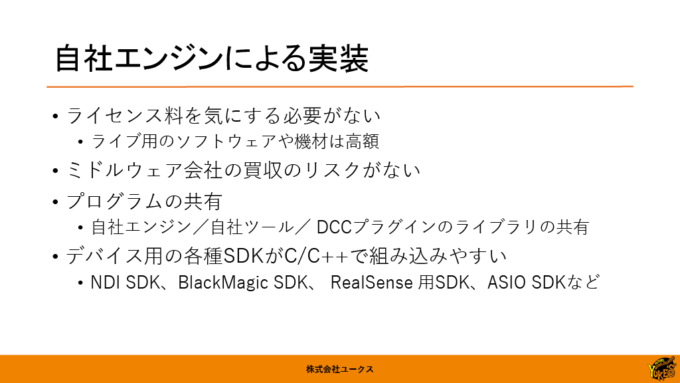

エンジンから自社開発

多くのバーチャルアーティストの開発現場では、UnityやUnreal Engineといった既製のゲームエンジンが用いられることが多い。だが、ALiS ZEROではエンジンからツールまで自社開発しているという。内製の理由は、ライセンス料の支払いやミドルウェア開発会社買収といったリスクがないからとのこと。

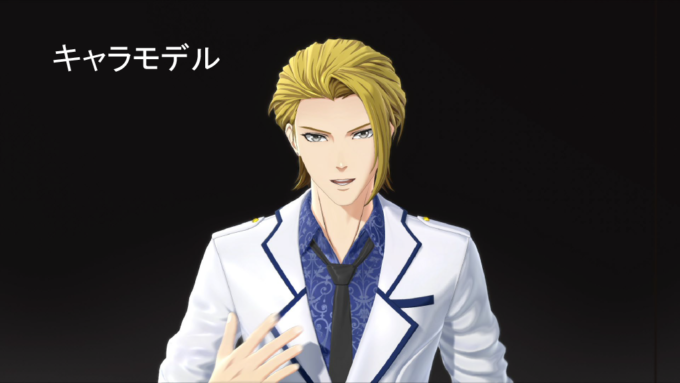

キャラクターモデルはハイエンドCGと同じクオリティーを追求し、Mayaのプリレンダーで作成された映像をリアルタイム表示で再現することを目指しているという。

臨場感を生み出すARライト、ARスモーク、ARカメラ、ARサウンドの実装

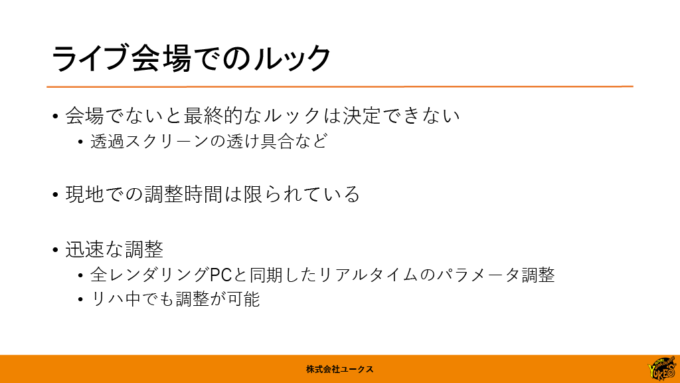

本講演でも特に丁寧に説明されていたのが、ライトへのこだわりだ。ALiS ZEROは、ライブ会場の照明演出などを制御するArt-Netというプロトコルと連動する仕組みを備えている。これにより、ライブ会場の照明とリアルタイムに連動した演出が可能だという。ライブ現場の照明担当をすべて制御できるため、照明担当者の判断でライブの中でも進化させられるところが強みだ。

これは、最終的なルック(見た目)はライブ会場でないと決定できないとの考えから。つまり、ライブ会場で最高の見え方になるように調整できるようにしているわけで、こだわりの表れと言えるだろう。

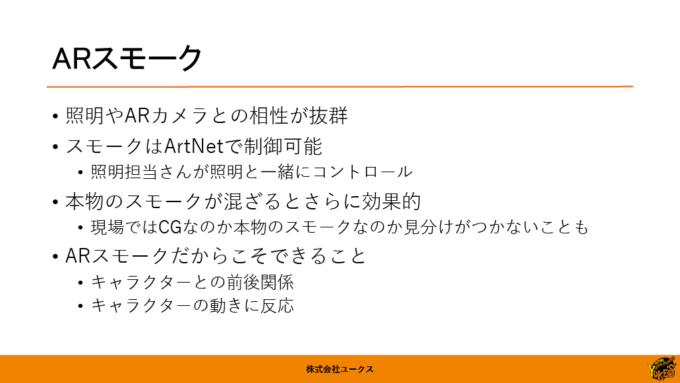

ARスモークもArt-Netで制御されている。本物のスモークとARスモークとが混ざることで、さらに効果的になるという。

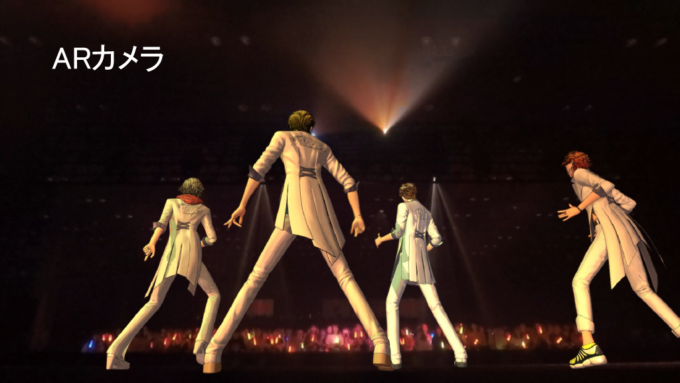

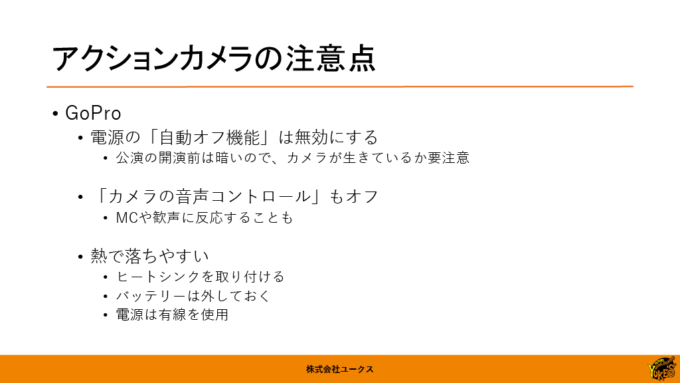

ARカメラは、ステージの後方から、パフォーマーの後ろ姿や客席を映す演出などに使われている。 実際には投下スクリーンの後ろに設置されたGoProカメラが使われている。動かしやすいアクションカメラであることを生かして、パフォーマーがステージ上でセルフィーを撮る演出にも使われた。

GoProを実際のライブで使う際の注意点も共有された。

ARサウンドは、パフォーマーの位置座標を意識させる上がりの演出や、ダンスの時の着地音などに活用されている。

配信専用ライブや配信番組における事例

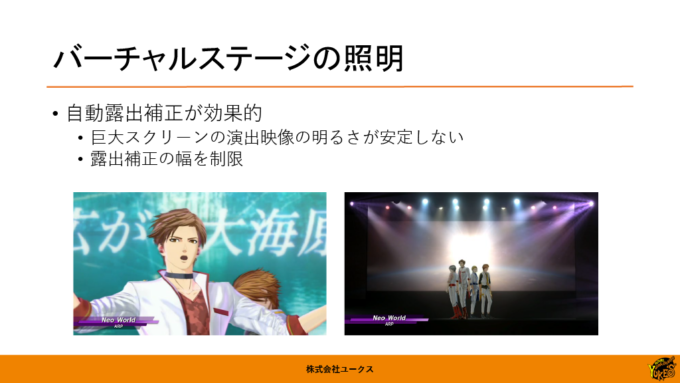

昨今増えてきた配信専用ライブや番組の場合、照明やカメラの演出もすべてバーチャルステージの中で完結する。バーチャルステージであっても、照明担当がArt-Netで照明演出をコントロールするところはリアル会場のライブと同じにしているという。

バーチャルステージでも実在感を出すために、自動露出補正を使った演出が効果的だとノウハウが明かされた。明暗が急に切り替わるシーンで、あえてカメラの露出調整で生ずるホワッとした見た目になる演出を入れることで、非常に効果的だったそうだ。

手持ちのバーチャルカメラとしては、RealSenseを使った機材を開発したという。

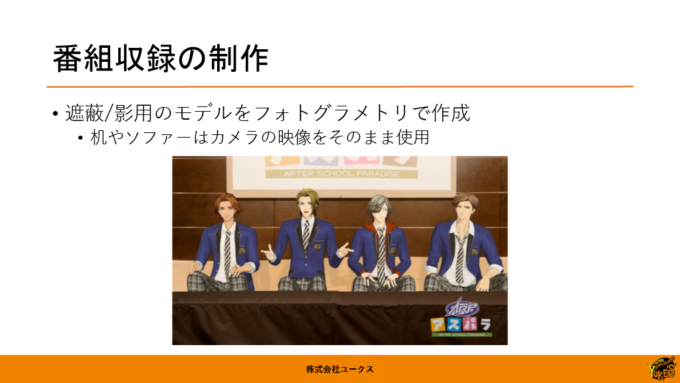

番組収録では、遮蔽物や影を表現するためにフォトグラメトリーを活用。机やソファーは実写の映像をそのまま使いつつ、そこにフォトグラメトリーで作った3Dモデルを透明にして重ね、遮蔽や影を表現するために使用する。

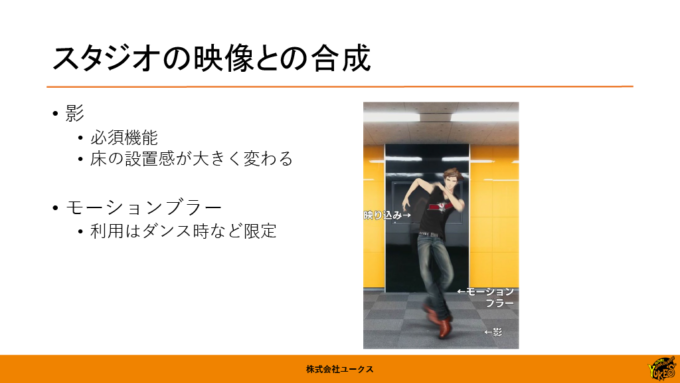

実写との合成では、影は床の接地感を出すために必須だという。ダンス時にはモーションブラーも入れている。

モーキャプにはVICONとVIVE Trackerを活用

モーションキャプチャーには光学式のVICONやOptiTrackを用いているが、内容によってはVIVE Trackerを使うこともあるという。

リップシンク(声に合わせて口を動かす処理)が最も遅延が発生するので、リップシンクにほかの全体の要素が合うように、生の音声やモーションキャプチャーの情報を微妙に遅延させて合わせているという。姿勢についても鎖骨の動きにまで気を使っている。

VIVE Trackerを使ったモーションキャプチャーのソフトウェアは、当初はiKinema Orionを使っていたが、自社開発ツールに切り替えたとのこと。筆者による邪推だが、冒頭に紹介されたミドルウェア会社買収のリスクとは、このiKinemaのことも含まれているかもしれない。

遠隔ライブでの実装上の工夫

会場の都合やコストの都合によって、モーションキャプチャースタジオと実際のライブ会場が離れてしまうこともある。そんな時にも、自社開発のツールによって様々な工夫が凝らされている。

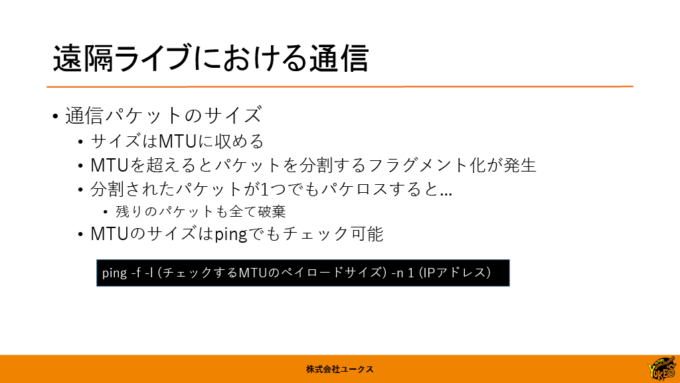

送信するデータは、ネットワークで送信できるデータサイズの単位であるMTU(Maximum Transmission Unit)に収まるように圧縮、調整をしているとのこと。

音声伝送にも、自社開発のConnectAudioというツールを使っているという。

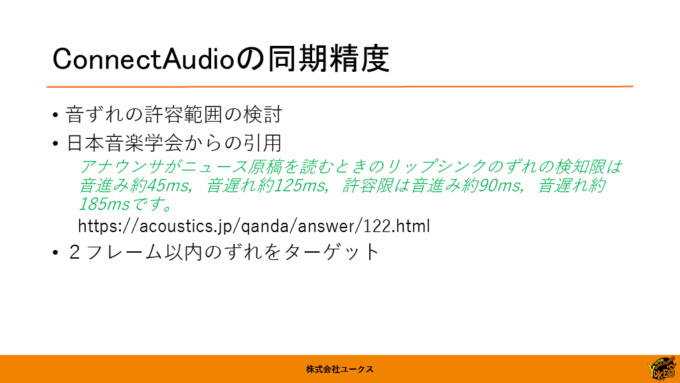

遠隔で収録するときに、気になるのが映像と音とのズレだ。日本音楽学会のQ&Aを参考に、2フレーム(60fpsの場合は約33ミリ秒)以内のズレになるように調整している。

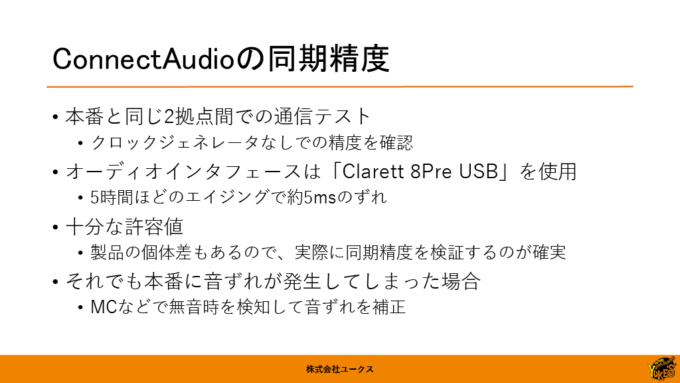

実際に通信テストを行ったところ、5時間でも5ミリ秒程度しかズレなかったため、同期のための特別なシステムは入れずに運用しているとのこと。念のために、本番中にMCなどのタイミングでズレを補正できる仕組みも入れている。

すべては良いライブを届けるために

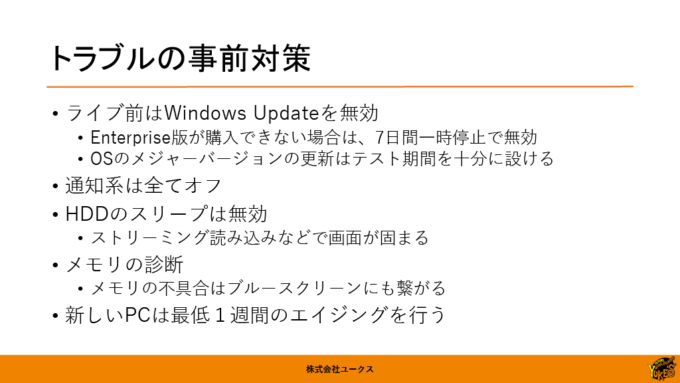

ライブにトラブルはつきもののため、事前に対策できるポイントも紹介された。新しいPCのエイジング(長時間の動作テスト)などは、たくさんの現場を経験してきたからこその観点と言えるだろう。

最後のスライドの末尾の文章に「ライブを楽しむ気持ち」と記述があったことがとても印象的だった。

(Text: Yuichi Matsushita)