Live2Dは25日、東京都千代田区にあるベルサール神田にてクリエイター向けの年次イベント「alive 2019」を開催した。Live2Dといえば平面のイラストを元に立体的なアニメーションを合成できるツールで、一般的に3Dでつくるよりも手間や制作費で有利なためVTuberでも採用例が多い。

そんな業界におけるLive2Dの活用例として、「にじさんじ」で知られるいちからによる「にじさんじアプリにおける 表情の豊かさの秘密」と題した講演が行われた。

最近、PANORAの「週間VTuberランキング」でも、にじさんじの動画・生放送が上位を占めているが、その人々を熱狂させる要因のひとつに、ライバーたちの表情の豊かさが挙げられるだろう。ファンやLive2Dエンジニアにとって非常に「ためになる」話ばかりだったので、ぜひ全編目を通してほしい。

あえてすべての表情を取らないアプリ側の工夫

「にじさんじ」といえば、今となってはバーチャルタレント事務所としての側面が目立っているが、2018年当初はiPhone Xを使いARkitの「アニ文字」機能でVTuberになれるアプリプラットフォーム事業からスタートしている(関連記事)。

イラストを元にLive2Dで動かせるようにモデリングして、iPhone Xで表情を認識してキャラクターを動かすという仕組みだ。このにじさんじアプリ自体は結局一般に公開していないが、今でも所属するバーチャルライバーにiPhoneとともに渡して使っている。

そんなにじさんじアプリは、もともとはネイティブアプリとしてCEOの田角氏が開発していたが、草彅氏が引き継いでから最終的なAndroid対応を視野に入れるためにUnityに移行した。その開発時には、唇、表情、感情という3つのトラッキングにおける問題点が発生した。

唇のトラッキング。人間が話すときは唇が思ったより動かない。「あいうえお」の口の形がきれいに取得できると話している感じが表現できるのだが、うまく取れなく苦労した。

表情のトラッキング。もともと草彅氏が1人で開発していたため、動かしやすい表情が自分の顔に最適化されていってしまった。各ライバーさんの無表情をセーブしておき、そこからの差分で唇や表情を動かすようにしたところ、どんな顔でもきれいに対応できるようになった。

感情のトラッキング。例えば、本気で怒ったり死ぬほど悲しむという状態にまで行かないと感情が表情に反映されないのは使いにくい。怒りなら、ある程度「怒ってますよ」という表情をすると、それがキャラ側に反映する仕様になっている。

結論としては、表情をそのままモデルにおとし込んでもいいアプリにならないということ。にじさんじアプリで言えば、眉毛をそのまま動かすのは難しいためある程度無視しており、唇の笑いや怒りに連動して眉毛も笑ったり怒るようにプログラム側で解決している。

また、人間の顔は必ずしも左右対称ではなく、例えば両目があっていない場合もある。それがモデルに反映されると美しくない動きになってしまうので、左右の平均をとってプログラム側で合わせている。あえて厳密にトラッキングしないことで、表情の豊かさを増しているというのが非常に興味深い話だ。

さらに「アプリのほうだけでキャラクター表現を高めるのは限界があるのでモデラーと協力する必要がある」と語って、野久保氏にバトンタッチした。

どんなキャラかきちんと想像して動きに落とし込む

まずはじめに語ったのが、「バーチャルライバーは表情が命」という話だ。バーチャルライバーはゲームに出てくるキャラと異なり、画面の右下や左下にずっと表示されて、下手すると数時間も配信してその間ずっと視聴者が見ていることになる。そこで顔のモデリングにアラがあったり、髪の毛の揺れがワカメのようにフニャフニャだったりすると視聴者が配信に集中できない。だから、表情を重点的にモデリングする必要がある。

今までのLive2Dモデリングは、ゲームアプリなど収録したモーションがメインだったが、バーチャルライバーではリアルタイムトラッキングがメインになるというのが大きな違いになる。モーションベースは、手や足などの体を動かしたり、炎などの演出を付与したりと感情を表現するための手段が豊富にある。一方、リアルタイムトラッキングベースでは、基本的に表情のみでモデルの感情を表さなければいけない。

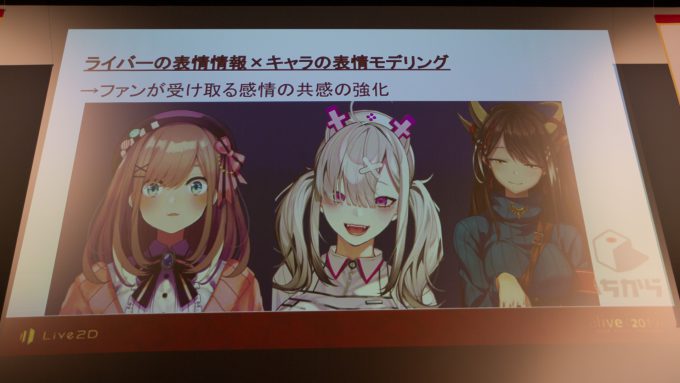

ライバーさんの楽しそうだったり、悲しそうだったり、怒っていたりする感情に、キャラの表情モデリングを乗算することで、配信を見たファンがその感情に強く共感できるようになる。

だから「すべてはそのモデリングにかかっている」。どうでもいい話ですが、先ほどの「バーチャルライバーは表情が命」といい、アニメ「アイカツ!」のアイカツ!格言にかかってますね……!

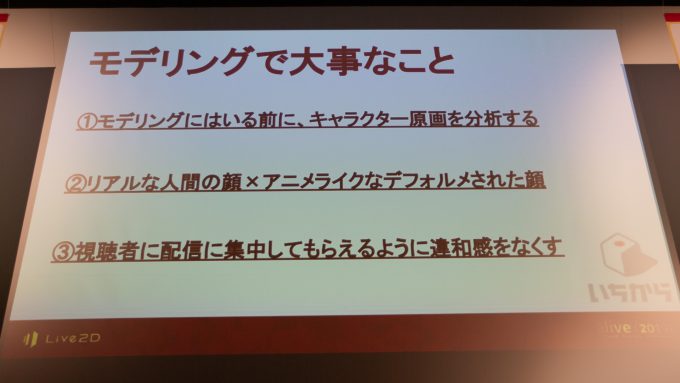

リアルタイムベースのLive2Dキャラクターをモデリングする際に大事なのは以下の3つ。

1.モデリング前にキャラクター原画を分析する

2.リアルな人間の顔×アニメライクなデフォルメされた顔

3.視聴者に配信に集中してもらえるように違和感をなくす

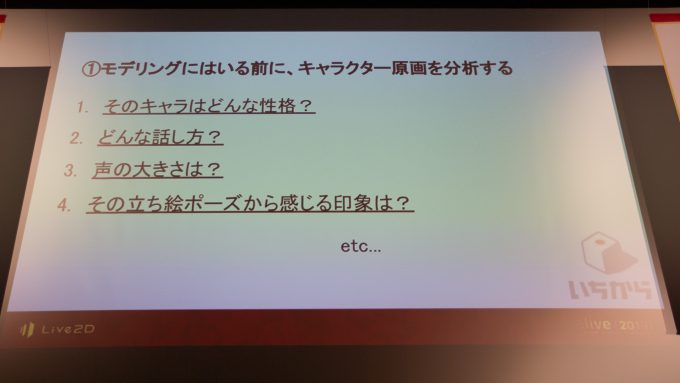

このうち、野久保氏がVTuberのモデリングで一番重要だと考えているのが1番のキャラクター分析だ。

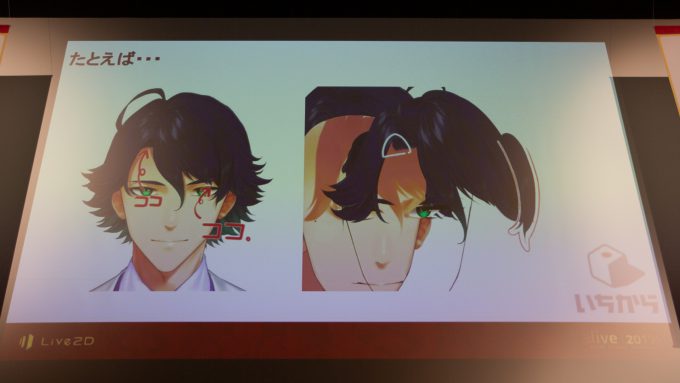

例えば、音楽において楽譜を分析して、音符一つ一つに意味を持たせていくように、キャラクターの性格や話し方、声の大きさ、立ち絵ポーズから感じる印象などを分析してモデリングの方向性を固めていく。

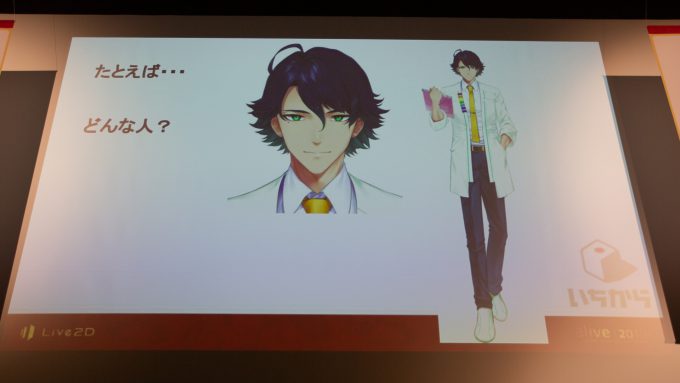

バーチャル登壇する予定だった下記キャラクターでいえば、「優しそう」「泣きぼくろついてて女の子にモテそう」「すらっとしている」「白衣を着ている」「大人しそう」……といった具合。そこから想像して、例えば口の開け方であれば「大口やおちょぼ口はないな」、動きは「激しくは動かないな」とイメージを固めていく。この分析が甘くて、テンプレのような動かし方をしてしまうと、ライバーさんの表情情報と合わせた際、乗算の力が弱まってしまう。

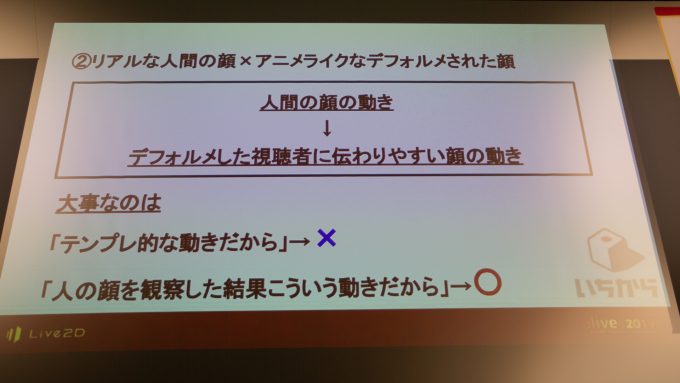

さらに興味深かったのが2番の「リアルな人間の顔×アニメライクなデフォルメされた顔」で、「みんなこういう風に動かしているから、このパーツはこう動かす」ではなく、きちんと人間の表情筋を観察した上で、デフォルメされた顔の動きに落とし込んでいくという意識づけが大切という話だ。

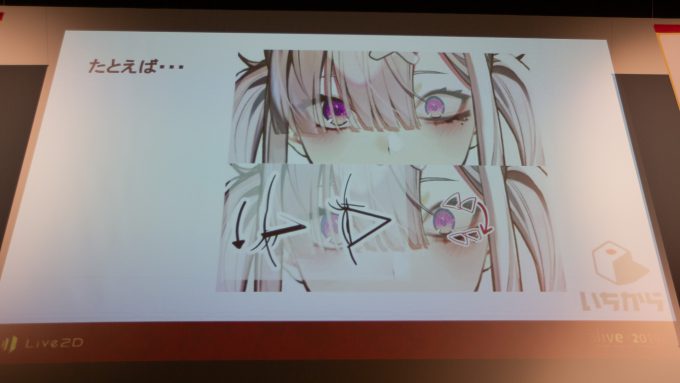

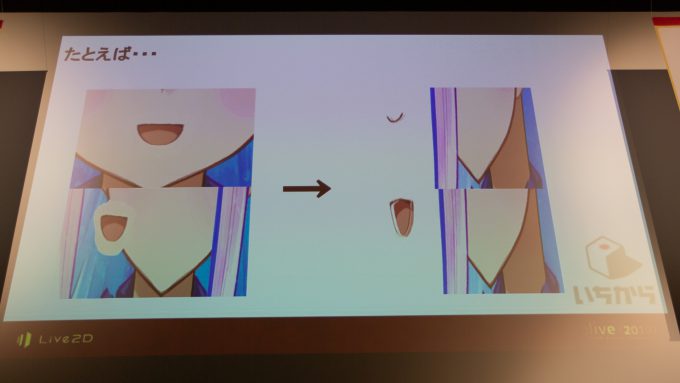

例えば「目パチ」について、単純に瞼を落とすのではなく、目が開いているときはまつ毛が上、閉じているときは下とモデリングをわける。

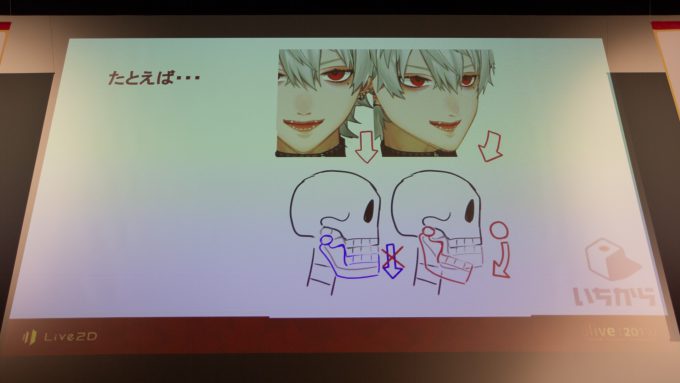

「口パク」でも、顎関節を軸に回転しているのを想像して、口が開くときは下顎を単純に下げるのではなく、内側に潜らせるようにする。

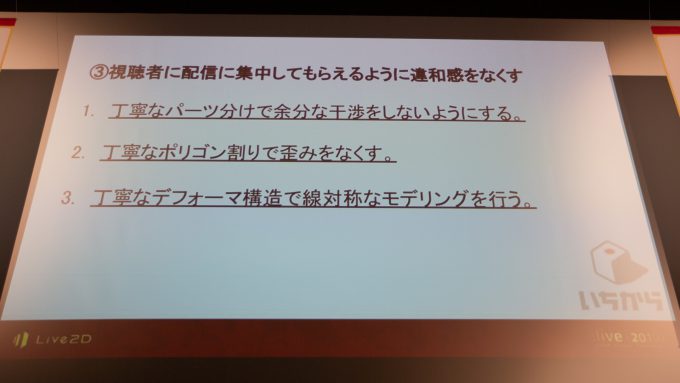

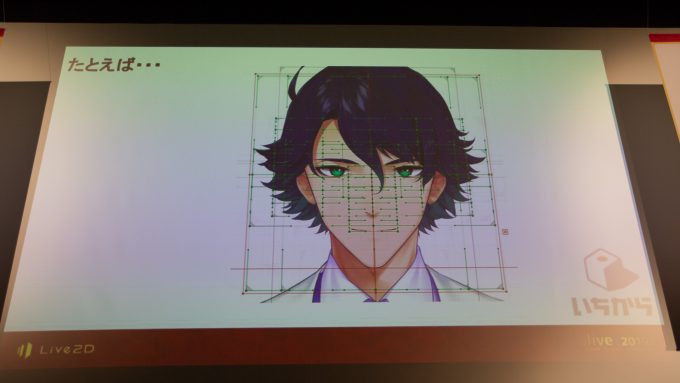

3番の「視聴者に配信に集中してもらえるように違和感をなくす」は、パーツわけやポリゴン割り、線対称なモデリングといった基本を丁寧にやるという話だ。

パーツわけは髪の毛で言えば、前髪のかかっている部分をわけたり、左側のM字のようになっているところに生え際を書いたりといった細かい工夫になる。

輪郭レイヤーにグラデーションをかけてしまうと、口パクをつくるときに口が広がって輪郭から出てしまうので、それを「目パチ」と同じ仕組みで解決する。モーションベースでユーザーが数秒しか見ないモデルなら左側でも問題ないが、配信で何時間も見続ける用途では細かく違和感を潰していくのがとても重要。

動かす際に必要になるデフォーマの構造も、左右対称にしておくと反転できるので作業の手間が軽減できる。

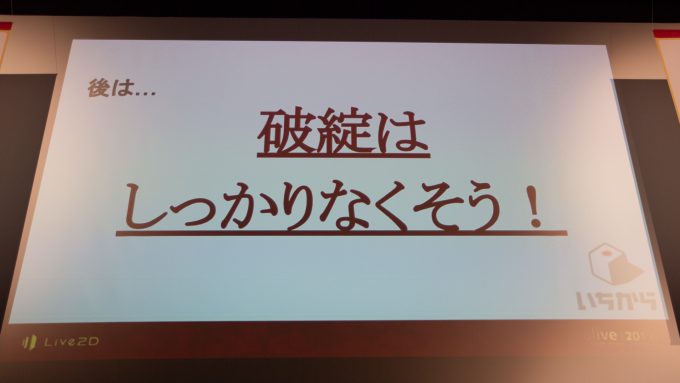

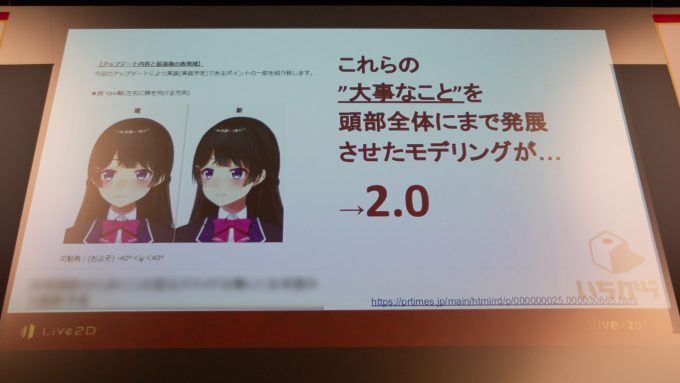

こうした要素を抑えたのが、昨年9月に発表した可動域が広い2.0モデルになる(ニュース記事)。可動域を広げるにはより多くのパーツを動かすことになるが、一方でパーツを動かせば動かすほど破綻しやすい。その破綻を潰すモデリングの苦労について、野久保氏は「ほとんど絵を描くのと同じ」と語っていた。

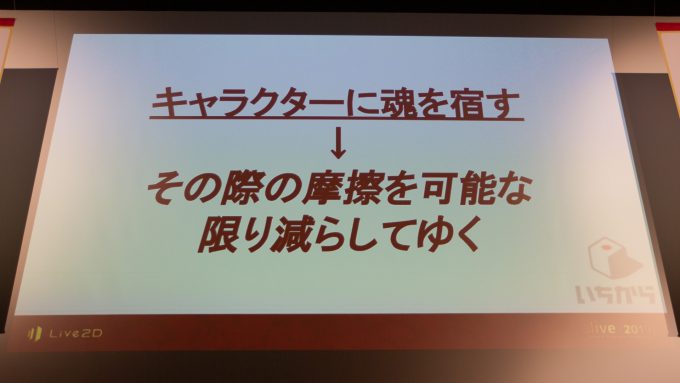

キャラクターに魂を宿すため、その際に起こる摩擦を可能な限り減らしているのが、いちからのLive2Dモデラー班になる。

ちなみに質疑応答にて、「実際にライバーさんが使うようになってからモデルの動かし方を修正することはあるのか?」という質問を投げたところ、野久保氏より「基本的にはライバーさんから修正してほしいという話があった場合だけ直す。ブランドがあるので表情は大きく変えない」との回答をもらえた。

最後に登壇者2人による「これからやりたいこと」トークと質疑応答があった。

「これからやりたいこと」では、草彅氏が「一番最初のときからARkitのバージョンが上がって舌のパラメーターが取れるようになった。実際に舌を出すかどうかは別として、何かやれないかとLive2D班と話している」と語ると、野久保氏が「例えば舌を出してる間は涙が出てくるとかの表現ができるかも」とコメントしていた。

また、2.0モデルで顔を左右方向に振った際の動きについて、「今は直線的だが、本来人間の体は顔を振ったちょっと後に体がついてくる。それをプログラミング側かLive2D側のどちらで解決するのがいいか模索している」と草彅氏が触れると、野久保氏は「個人的には、回転速度を調整したりして筋肉の弾性まで再現したい」との展望を示した。

ひとくちにLive2Dモデルといっても、作り手によってキャラクターの魅力が大きく変わってくるのが非常によくわかる講演だった。いちからはLive2Dエンジニアを募集中ということで、興味のある方はぜひ応募してみてはいかがだろう。

(TEXT by Minoru Hirota)